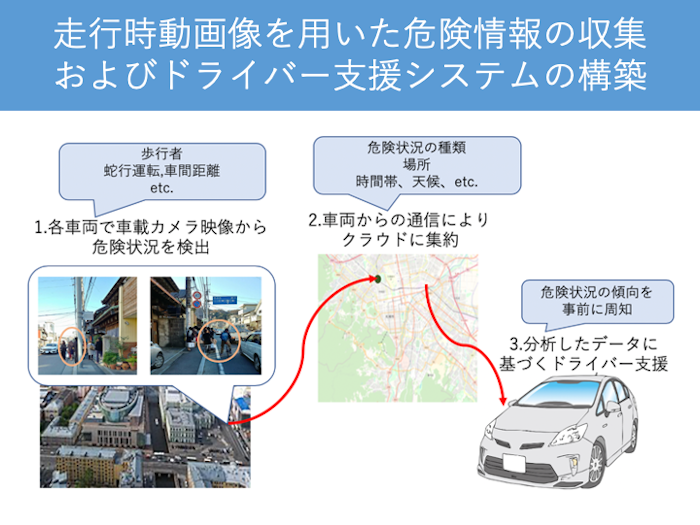

近年,車載カメラを搭載した車両が増加しているが,一般車両による車載カメラの映像は交通事故が起きたい際などに提出される一部のものを除き,そのほとんどが有効に活用されていないのが現状である.しかし,車載カメラの映像はうまく活用することで渋滞規模の把握や交通事故の削減など,さまざまな目的で使用することが可能である.

一方,膨大な量のカメラ映像を収集・処理し,活用するためには高速で安価なシステムの構築が必須となる.近年は深層学習の発展により,動画像中の物体を把握することは可能になってきており,映像内の他車両や歩行者といった自車両の周辺に存在する物体を認識することはできる.しかしながら,これら周辺物体と自車両間の距離,自車両の速度など,周辺物体との位置関係を把握するためには,カメラの画角,設置高,設置角度など,カメラの特性や向きなどを必要とし,車両ごとにこれらの入力を必要とするシステムは現実的ではない.また,自動運転車両などで実用されている車線認識技術を用いれば自車両と周辺物体との位置関係を把握することが可能であるが,多くの一般車両で自動運転車両と同じ車線認識を行うことはセンサやカメラの数や性能の差から難しいと言える.

そこで本取組では,自車両の周辺状況の把握に際し,自車と周辺物体の位置関係の把握や距離を推定するために,単眼カメラで撮影された動画像のみから,自車両と周辺物体の位置関係の基準となる複数車線の検出を行う手法を提案しています.

関連論文

- 塚本幸宏, 石崎雅大, 廣森聡仁, 山口弘純, & 東野輝夫. (2020). 走行時動画像を用いた多車線検出および補完手法. 研究報告高度交通システムとスマートコミュニティ (ITS), 2020(6), 1-7.

- Yukihiro Tsukamoto, Tatsuya Amano, Akihito Hiromori, Hirozumi Yamaguchi and Teruo Higashino, "Road Segment Re-Identification in Dashcam Videos", Proceedings of the 14th International Workshop on Selected Topics in Mobile and Wireless Computing (STWiMob 2021), pp. 19-24

- Yukihiro Tsukamoto, Masahiro Ishizaki, Akihito Hiromori, Hirozumi Yamaguchi and Teruo Higashino, "Multi-Lane Detection and Tracking Using Vision for Traffic Situation Awareness", Proceedings of the 16th IEEE International Conference on Wireless and Mobile Computing, Networking and Communications (IEEE WiMob2020)